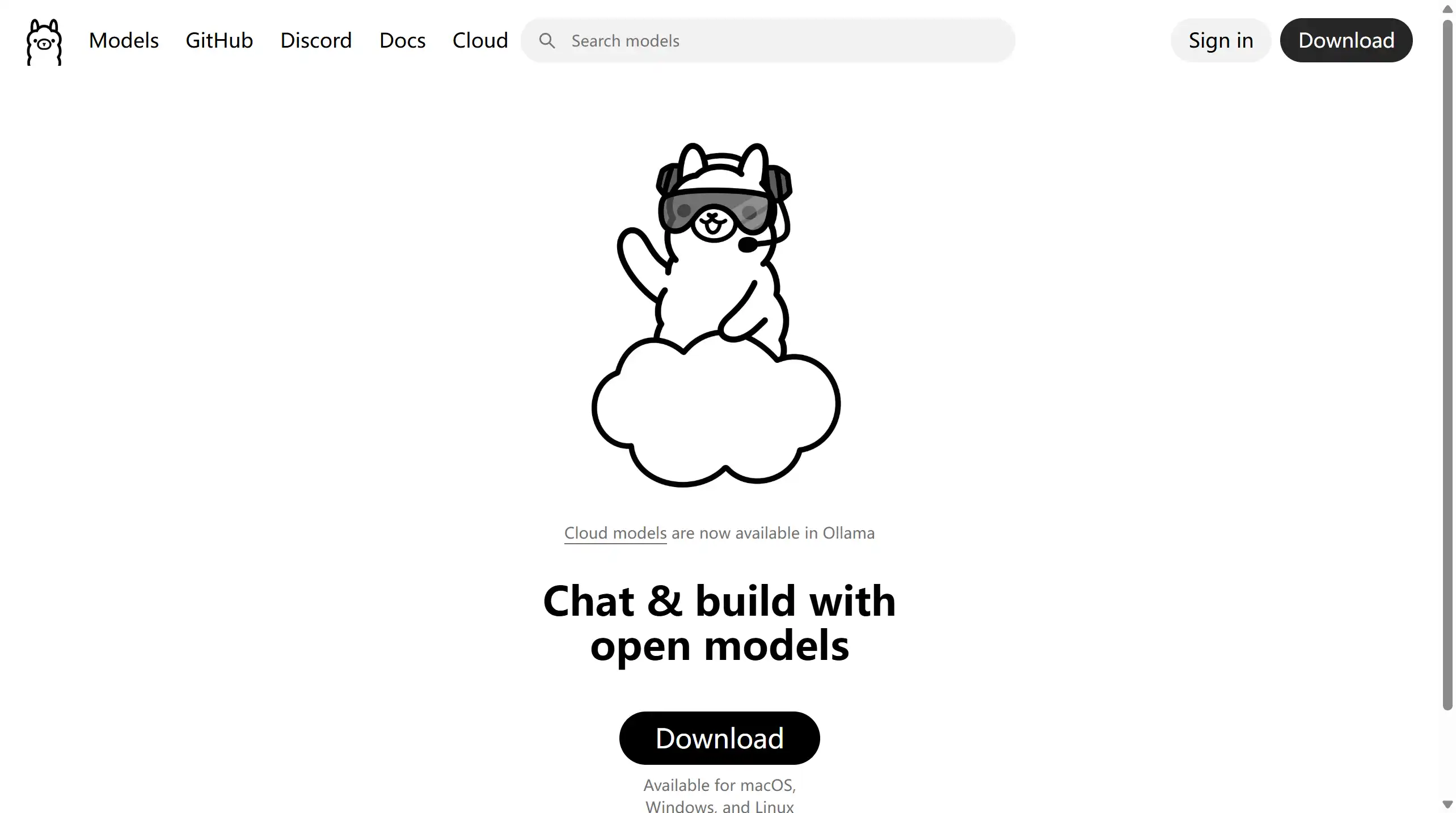

随着大模型应用的普及,越来越多开发者希望在本地环境运行语言模型,而非依赖云端接口,以确保隐私、安全与低延迟体验。然而,传统部署过程复杂、依赖项繁多,令许多人望而却步。Ollama 正是为了解决这一问题而诞生的开源工具。它让开发者可以轻松在个人电脑上运行如 Llama 2、Mistral、Gemma 等主流语言模型,无需服务器或复杂配置,真正实现「一键本地推理」。

Ollama 是什么?

Ollama 是一款由 Go 语言编写的本地语言模型运行软件,支持直接在 Linux、macOS 与 Windows 系统中部署与执行大语言模型(LLM)。该项目以 MIT 开源许可协议 发布,允许开发者自由下载、修改与分发。

其设计理念是让 AI 模型像应用程序一样轻量、可控、易于集成,使个人用户与企业团队都能便捷地在本地运行各种语言模型。

核心功能

Ollama 的功能重点在于 简化本地大模型运行流程,同时保证性能与跨平台体验。它面向开发者、AI 工程师与科研用户,提供了完整的模型加载、管理与交互能力。

- 一键运行语言模型 —— 输入命令即可在本地启动 Llama 2、Mistral、Gemma 等模型实例。

- 跨平台支持 —— 原生支持 macOS、Linux 与 Windows,无需额外虚拟化环境。

- 模型管理系统 —— 提供模型下载、缓存与更新机制,支持自定义模型导入。

- 本地 API 接口 —— 通过 REST 或命令行方式调用模型输出,便于与前端或其他应用集成。

- GPU 与 CPU 自动适配 —— 根据硬件配置智能分配推理资源,提高运行效率。

- 隐私保护 —— 所有数据处理均在本地完成,无需云端传输,确保信息安全。

- 轻量化安装 —— 通过简单命令即可安装,无需复杂依赖。

- 开放源码生态 —— 允许二次开发与模型扩展,满足个性化研究与实验需求。

使用场景

Ollama 适用于开发者、研究人员、AI 应用构建者与注重数据安全的企业。不同角色可在各自任务中灵活利用本地模型能力。

| 人群/角色 | 场景描述 | 关键步骤要点 | 推荐指数 |

|---|---|---|---|

| 开发者 | 本地调试与集成 AI 功能 | 下载 Ollama,加载模型,通过 API 调用接口 | ★★★★★ |

| AI 研究员 | 测试不同模型性能与效果 | 切换多种模型进行实验性推理 | ★★★★☆ |

| 企业团队 | 构建私有化 AI 助手 | 在内网环境中本地运行模型 | ★★★★★ |

| 数据安全工程师 | 需要离线环境运行模型 | 关闭外网,仅本地调用模型接口 | ★★★★★ |

| 教育/培训机构 | 用于教学与示范 | 快速搭建教学环境,展示模型推理过程 | ★★★★☆ |

| 独立开发者 | 构建本地 AI 工具或插件 | 结合 Ollama CLI 与脚本自动化 | ★★★★☆ |

操作指南

Ollama 的安装与使用非常简洁,用户可在 3 分钟内完成环境搭建并运行模型。

- 前往 Ollama 官网 下载适合系统的安装包。

- 安装完成后,打开终端或命令行界面。

- 输入命令

ollama run llama2启动模型。 - 等待模型自动下载与加载(仅首次运行时需要)。

- 运行成功后,可直接在命令行中输入文本进行交互。

- 使用

ollama pull mistral下载其他模型。 - 使用

ollama list查看本地模型列表。 - (提示)可通过 REST API 接口实现程序化调用,详细文档可在官网查阅。

支持平台

Ollama 原生支持 Linux、macOS 与 Windows 三大主流操作系统,并兼容 x86 与 ARM 架构。

得益于 Go 语言跨平台特性,用户可以在笔记本、台式机甚至服务器上直接运行,无需额外容器或虚拟机环境。部分 GPU 加速功能依赖 NVIDIA CUDA 或 Apple Metal 驱动,在高性能设备上可显著提升推理速度。

产品定价

Ollama 完全 免费开源,以 MIT 协议发布。

用户可自由使用、修改与分发源码,无需支付授权费用。

对于需要企业支持或集成服务的用户,可通过其社区或 GitHub 参与协作与技术交流。

常见问题

Q:Ollama 是否需要联网才能运行?

A:首次下载模型时需要联网,之后即可离线使用,所有推理过程均在本地执行。

Q:支持哪些语言模型?

A:Ollama 目前支持 Llama 2、Mistral、Gemma 等模型,并持续增加对新模型的兼容。

Q:是否占用大量显存或硬盘空间?

A:根据所选模型不同,占用空间约为 2GB–15GB。小型模型可在普通笔记本上流畅运行。

Q:能否在无 GPU 的设备上使用?

A:可以,Ollama 会自动切换至 CPU 推理模式,但响应速度相对较慢。

Q:是否支持二次开发?

A:支持。Ollama 提供命令行工具与 REST API,可集成到本地应用或研究项目中。

开发者小结

Ollama 是一款极具实用价值的本地语言模型运行平台,尤其适合希望离线运行 AI 模型、保护隐私与自主控制计算资源的用户。其跨平台特性、命令行与 API 兼容性,使其在科研、教学、产品开发等场景中均能灵活使用。

对于重视可控性与性能的开发者而言,Ollama 提供了一个稳定、透明、可扩展的基础环境;而对于仅想体验模型能力的个人用户,它又足够简单易用。唯一的限制是模型体积较大,对硬件性能有一定要求,但总体来看,Ollama 是迈向本地智能计算的重要一步。

关键词:Ollama,本地语言模型,Llama 2,Mistral,Gemma,AI推理,Go语言,开源工具,跨平台,离线运行,隐私安全,人工智能

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...