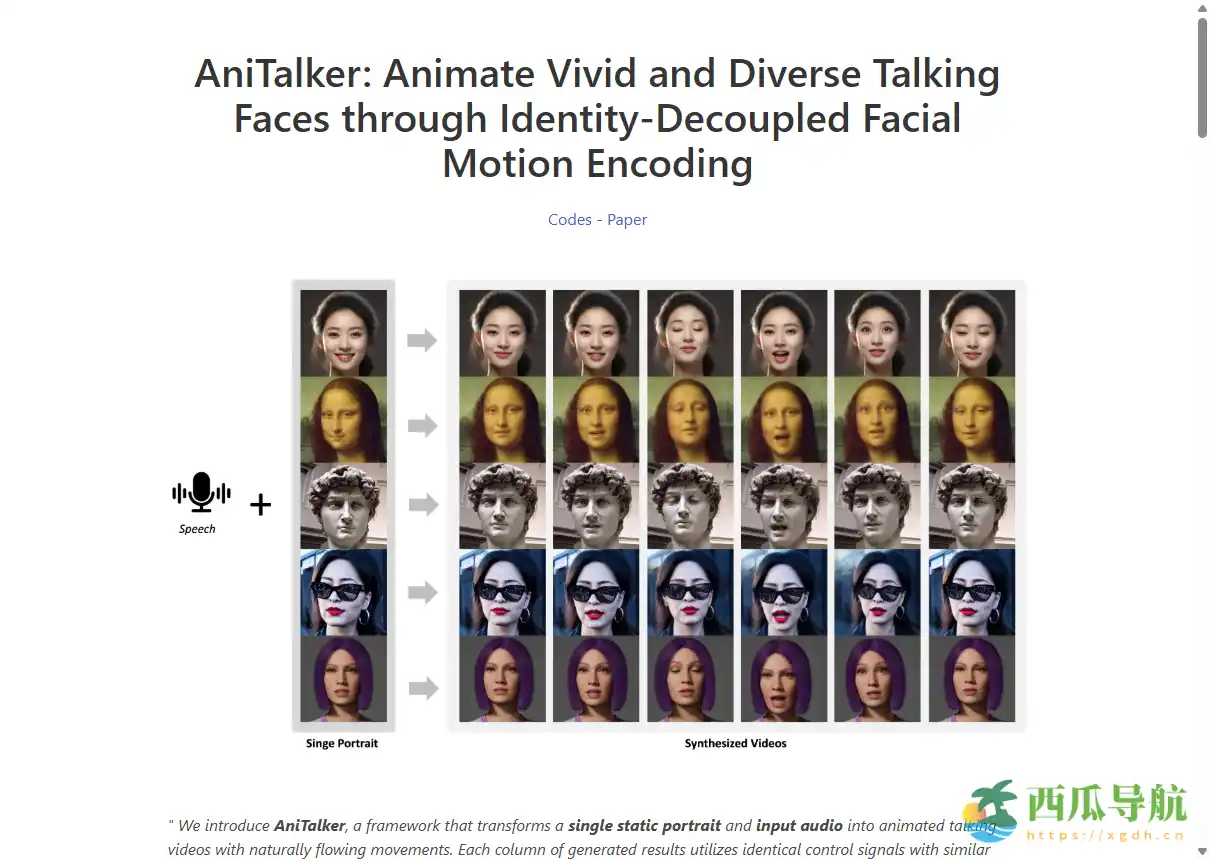

许多研究者和内容创作者希望将静态肖像转化为自然生动的动画视频,但传统模型往往只能处理唇形同步,难以捕捉面部微表情和头部动作。AniTalker提供了一个开源框架,将单张静态照片与音频输入结合,生成栩栩如生的说话面孔,实现自然流畅的面部动态表现,极大拓展了动画视频生成的可能性。

AniTalker是什么?

AniTalker是一款开源照片+音频视频生成框架,能够将单个静态肖像与音频输入转换为动态面部视频。其创新之处在于采用身份解耦的面部运动编码方法,捕捉微妙表情和头部动作,并通过扩散模型和方差适配器生成多样化且可控的动画视频。AniTalker适合研究者、开发者和创作者探索虚拟人物动画和交互式视频制作。

网站地址:https://x-lance.github.io/AniTalker

核心功能

AniTalker面向AI研究者、开发者及内容创作者,提供精准、可控、真实的动态面部视频生成能力。

- 静态肖像转动态视频——将单张照片和音频生成自然流动的说话面孔。

- 面部运动编码——捕捉微表情和头部动作,提升动画真实感。

- 多样性生成——使用方差适配器生成随机微变化的视频结果。

- 身份解耦——确保运动编码与特定身份无关,减少对标注数据需求。

- 自监督学习策略——通过源帧重建和度量学习增强运动表示。

- 扩散模型集成——生成高质量、可控面部动画。

- 开源框架——方便研究者和开发者定制和集成到自己的项目。

- 高效控制信号——可对姿势和表情进行精确调整。

使用场景

AniTalker适合研究人员、AI开发者、数字创作者及教育培训用户,用于动态头像制作、虚拟主播、动画短片创作和交互式内容生成。

| 人群/角色 | 场景描述 | 推荐指数 |

|---|---|---|

| AI研究者 | 面部动态建模和视频生成实验 | ★★★★★ |

| 开发者 | 集成动态头像或虚拟角色到应用 | ★★★★★ |

| 数字创作者 | 制作短视频、动画角色或虚拟主播 | ★★★★☆ |

| 教育培训 | 创作可互动的教学视频内容 | ★★★★☆ |

| 内容爱好者 | 将静态肖像转为生动动画视频 | ★★★★☆ |

操作指南

新手可在几分钟内体验AniTalker基本功能:

- 克隆AniTalker开源项目到本地或服务器环境。

- 准备单张肖像图片与对应音频文件。

- 根据文档安装必要依赖,包括Python库和模型文件。

- 执行生成脚本,输入图片路径和音频路径。

- 调整参数控制面部表情、姿势和多样性生成。

- 查看输出视频,保存或进行后续处理。

- (注意)确保计算资源充足,高分辨率视频生成可能需要GPU支持。

支持平台

AniTalker为开源框架,支持Linux、Windows和macOS环境,可在本地或服务器运行,适配Python环境,并可与其他深度学习工具链集成。

产品定价

AniTalker完全开源,免费使用,用户可根据需求修改和扩展功能。

常见问题

Q1:是否需要注册账号?

A:无需注册,开源项目可直接下载和使用。

Q2:生成视频是否安全?

A:所有处理在本地完成,用户数据不上传,确保隐私安全。

Q3:是否收费?

A:AniTalker开源免费,无任何付费限制。

Q4:是否支持多样化面部动作?

A:支持,通过扩散模型和方差适配器实现随机微变化。

Q5:是否需要大量标注数据?

A:采用自监督学习策略,显著减少对标注数据依赖。

跳跳兔小结

AniTalker适合研究人员、开发者和数字创作者,用于将静态肖像转化为栩栩如生的动态面部视频。优势在于身份解耦、多样性生成和开源自由度,但高分辨率或长时段视频生成需要较高计算资源。整体来看,AniTalker是探索面部动画和虚拟角色内容制作的强大工具。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...