科研与数据分析领域对高效信息整合与深度验证的需求日益增长。传统搜索工具或AI助手往往只能提供浅层回答,缺乏系统化分析与可追溯的研究支撑。而 Local Deep Research 正是为此而生——它将主流大模型能力与多源数据检索相融合,打造出一款可在本地运行的智能科研助手。用户既可通过云端模型(如 Claude、GPT)获得强大的语言理解与生成能力,又能在完全离线环境中保障数据隐私,实现高效、安全、可验证的研究分析全过程。

Local Deep Research 是什么?

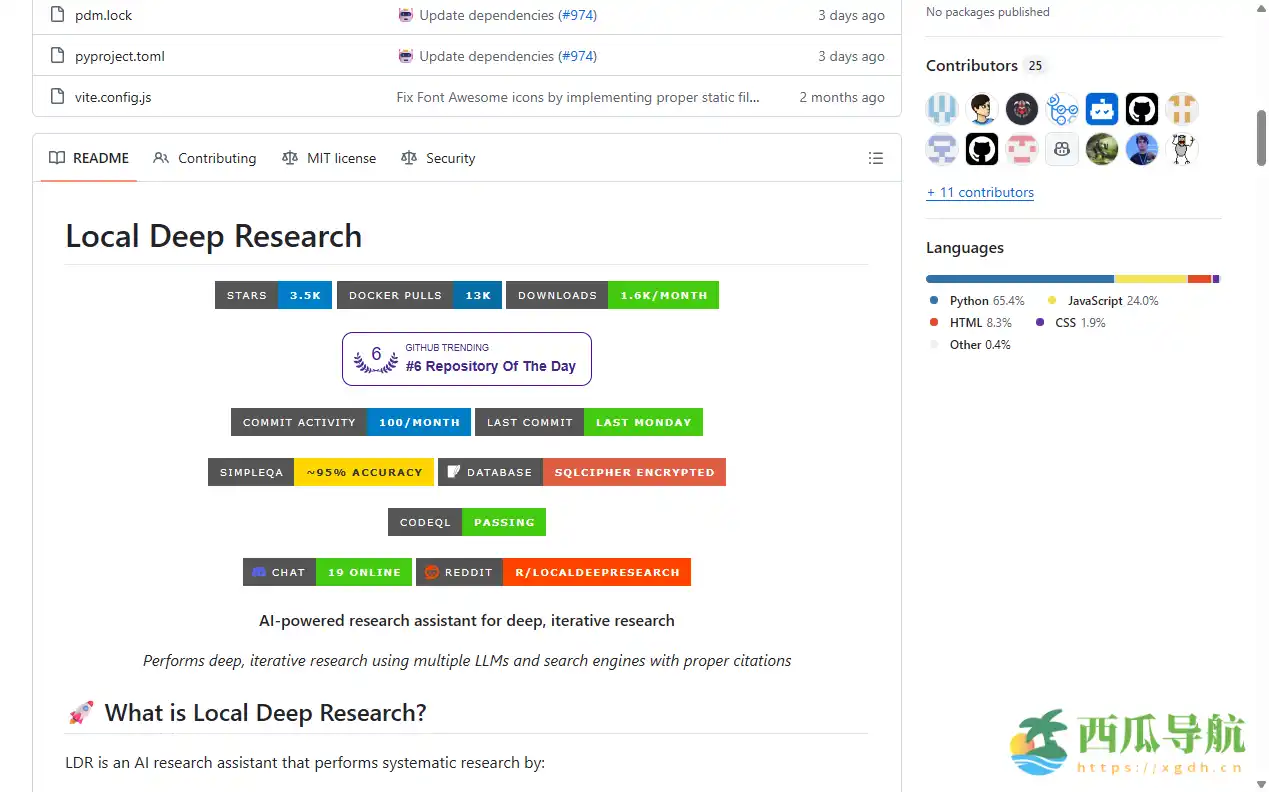

Local Deep Research 是一款集成 AI 推理、知识检索与文献整合功能的科研辅助平台。它结合了大模型智能生成与网页搜索分析,能够自动提取、交叉验证和整合来自学术与新闻数据源的信息,为用户生成深度研究报告与精准摘要。系统支持 本地运行与云端协同,可灵活调用 Ollama、Langchain 等模型框架,并通过向量嵌入技术实现本地文档的语义检索,覆盖 PDF、文本与 Markdown 等主流格式。对于科研人员、分析师与信息工程师而言,它是一款兼顾 隐私、安全与精度 的综合研究助手。

开源地址:https://github.com/LearningCircuit/local-deep-research

核心功能

Local Deep Research 聚焦科研与知识整合场景,通过模块化架构提供多维度的分析工具与自动化流程。

- 多模型融合——集成 Claude、GPT、Ollama 与 Langchain 模型,满足不同精度与性能需求。

- 本地与云端并行——支持离线运行保障隐私安全,也可启用云端大模型增强生成能力。

- 网页深度抓取——自动提取网页正文、引用和上下文,实现完整的信息收集。

- 自动生成研究问题——系统可根据用户输入主题自动提出延伸性问题,助力深度探索。

- 引用追踪与来源验证——为每条分析结论提供出处标注,方便交叉核对与引用。

- 智能搜索引擎集成——覆盖 Wikipedia、arXiv、PubMed、DuckDuckGo、SerpAPI、Google Programmable Search、The Guardian 等权威来源。

- 本地文档向量检索——通过嵌入式索引实现精准语义检索,支持 PDF、TXT、MD 文件格式。

- 自动化报告生成——可输出结构化研究报告、摘要与结论,便于学术整理与团队共享。

使用场景

Local Deep Research 适合科研、学术、媒体与商业分析等多种任务环境。无论是撰写论文、进行学术调研,还是进行市场趋势分析,系统都能提供强大的信息聚合与验证支持。

| 人群/角色 | 场景描述 | 推荐指数 |

|---|---|---|

| 科研人员 | 整合多源论文与数据撰写研究报告 | ★★★★★ |

| 数据分析师 | 从新闻与数据库中提取趋势洞察 | ★★★★★ |

| 教育机构 | 辅助学生完成论文查证与资料整理 | ★★★★☆ |

| 媒体编辑 | 验证新闻来源与交叉引用数据 | ★★★★☆ |

| 独立研究者 | 离线运行保障隐私的个人研究分析 | ★★★★★ |

操作指南

Local Deep Research 的安装与使用流程清晰,用户可在 5 分钟内完成从部署到第一次研究任务的配置。

- 打开官网并选择「下载或部署」。

- 根据系统提示选择运行模式(本地 / 云端)。

- 安装依赖组件并配置所需模型(如 GPT、Claude 或 Ollama)。

- 导入待研究的文件或输入研究主题。

- 选择「启动深度研究」按钮,系统自动抓取并分析相关网页数据。

- 查看生成的摘要与引用来源,可点击条目跳转至原始文献。

- 使用「导出报告」功能生成 Markdown 或 PDF 格式文件。

- (可选)通过配置界面添加自定义搜索源与向量库。

(提示:若在本地运行,请确保设备具备足够的显存与存储空间,以保证模型推理流畅。)

支持平台

Local Deep Research 提供跨平台支持,兼容 Windows、macOS、Linux 系统,并可通过命令行或桌面客户端使用。对于移动端用户,可使用 Web 界面进行远程研究任务管理。系统还支持 Docker 部署与云端虚拟机运行,便于企业团队统一管理计算资源,实现本地与云端无缝衔接。

产品定价

Local Deep Research 当前为 免费 使用,用户可自由下载安装与本地部署。

若选择使用云端模型(如 GPT 或 Claude),需根据各模型的 API 调用规则支付相应费用。

官方还提供可扩展的企业版服务,支持多用户协作与私有数据索引功能,适合科研院所与数据实验室使用。

常见问题

Q:Local Deep Research 的隐私保护机制如何?

A:系统默认在本地执行所有分析与文档索引,不上传任何数据。若调用云端模型,可选择仅上传匿名化文本内容。

Q:是否需要联网才能使用?

A:若使用本地模型(如 Ollama 或 Langchain),可完全离线运行;若启用网页抓取与云模型功能,则需网络连接。

Q:可否自定义数据源?

A:可以。用户可在设置中添加自定义搜索引擎 API 或指定特定数据库接口,实现专属知识库扩展。

Q:生成的研究报告是否可靠?

A:每一条引用内容均附带来源链接与时间戳,用户可人工复核,确保结论的透明性与可验证性。

Q:对计算机配置有何要求?

A:若本地运行大模型,建议使用 16GB 以上内存与 8GB 显存显卡;云端模式无硬件限制。

跳跳兔小结

Local Deep Research 将科研助手的功能提升到了一个新的层次——它不只是“问答工具”,而是一个可自动检索、验证与整合信息的智能研究系统。对于科研工作者、分析师或教育机构而言,这款工具能显著减少资料查找与交叉验证的时间,提升研究效率与质量。它的本地部署特性也让隐私安全得以保障。

不过,如果仅需日常搜索或简易问答功能,Local Deep Research 的配置可能显得略为复杂,更适合追求高精度与强定制化的专业用户。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...