在生成式 AI 快速发展的阶段,模型与外部世界的连接能力正成为核心竞争力。无论是网页浏览、文件处理还是自定义任务调度,开发者都希望让大型语言模型(LLM)具备更广泛的操作能力。MCP-Use 正是为此而生的开源客户端库。它基于 MCP(模型上下文协议) 标准,为不同厂商的语言模型提供统一接入层,让模型可通过自定义代理安全访问任意工具和数据源,从而构建具备真实操作能力的智能体系统。

MCP-Use 是什么?

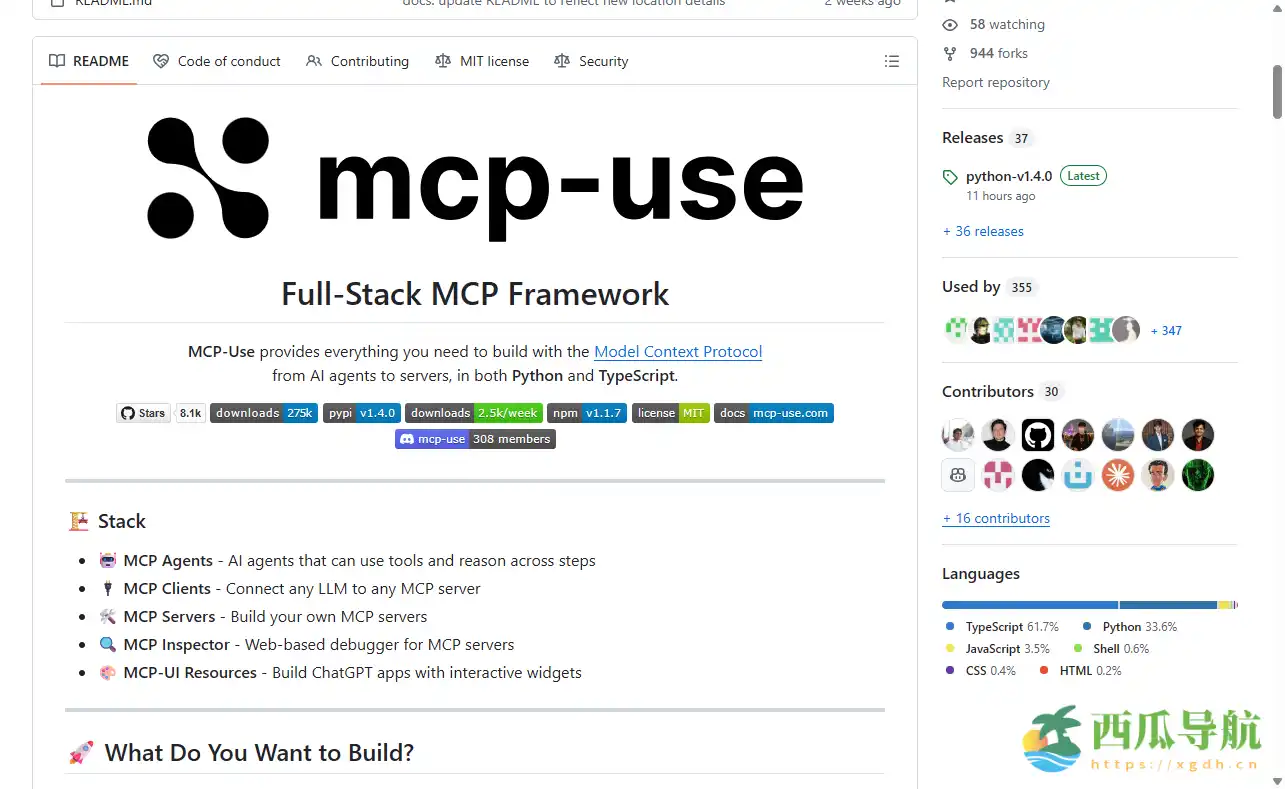

MCP-Use 是一个基于模型上下文协议(Model Context Protocol, MCP)的开源客户端库,旨在为 LLM 提供通用的工具访问能力。该协议由多家模型厂商和开源社区共同推动,目的是让模型能以标准化方式调用外部服务。MCP-Use 作为连接层,允许 OpenAI、Anthropic、Groq、LLaMA 等模型通过代理直接访问 MCP 服务器,实现浏览网页、操作文件、控制终端或调用第三方 API 等操作。

与传统的插件机制不同,MCP-Use 不依赖固定服务接口,而通过统一协议桥接任意工具,降低了 AI 应用开发的耦合度。其简洁的实现方式,使得开发者在仅数行代码内即可创建具备工具访问能力的模型代理。

网站地址:https://github.com/mcp-use/mcp-use

核心功能

MCP-Use 聚焦于“让任何模型都能安全使用任何工具”。它提供了一系列高效、灵活的功能,帮助开发者构建可控、可扩展的智能代理体系。

- 快速创建代理 —— 只需六行代码,即可生成具备 MCP 能力的语言模型代理,显著降低接入门槛。

- HTTP 直连支持 —— 允许客户端通过 HTTP 端口与远程 MCP 服务器交互,适配分布式或跨平台部署。

- 动态服务选择 —— 代理可根据任务类型,从配置池中自动挑选最合适的 MCP 服务节点,提高执行效率。

- 多服务器并行接入 —— 支持在单一代理实例中同时连接多个 MCP 服务器,实现跨领域工具协作(如网页搜索+3D 建模)。

- 访问控制机制 —— 允许开发者禁用高风险功能(如文件系统或网络访问),保障系统安全与合规。

- 可扩展架构 —— 基于开源协议设计,支持自定义插件与自研工具快速挂载。

- 跨模型兼容性 —— 兼容多种主流 LLM 架构,确保不同模型间可共享同一 MCP 工具集。

使用场景

MCP-Use 适用于开发 AI 智能体、企业自动化系统及具备工具调用能力的 LLM 应用,覆盖研发、运维、内容生成等多个领域。

| 人群/角色 | 场景描述 | 推荐指数 |

|---|---|---|

| AI 开发者 | 构建具备浏览与操作能力的多模态代理 | ★★★★★ |

| 企业工程师 | 将 LLM 集成至自动化流程或监控系统 | ★★★★☆ |

| 安全研究者 | 测试工具调用安全性与访问权限设计 | ★★★★☆ |

| 教育机构 | 教学与演示模型工具调用原理 | ★★★☆☆ |

| 开源贡献者 | 扩展 MCP 生态、开发新型连接插件 | ★★★★★ |

操作指南

MCP-Use 的上手成本极低,新手可在几分钟内完成代理创建与连接配置。以下是基础步骤:

- 在命令行安装依赖库:

pip install mcp-use或npm install mcp-use。 - 引入库文件:

from mcp_use import Agent。 - 通过

Agent()创建新代理实例。 - 在配置中指定目标 LLM 与 MCP 服务器地址。

- 调用

agent.connect()建立通信通道。 - 使用

agent.run(task)执行具体任务,如网页爬取或文件读取。 - (可选)通过配置文件定义安全策略,禁用高风险模块。

- 验证输出结果与日志,确认代理执行效果。

(注意:不同语言实现的 API 语法可能略有差异,建议参考官方文档示例。)

支持平台

MCP-Use 采用跨平台架构设计,支持多种开发与运行环境:

- Web 环境:可通过浏览器或 WebSocket 实现远程 MCP 代理通信。

- 命令行与本地部署:兼容 Python、Node.js 等主流语言运行环境。

- 云原生集成:支持容器化部署及云端工具注册,适配企业级工作流。

- 模型适配层:适用于 OpenAI、Anthropic、Groq、LLaMA 等多种 LLM。

产品定价

MCP-Use 为 完全免费 的开源项目,遵循 MIT 开源许可协议。开发者可自由使用、修改与二次分发,不受商业限制。若搭配私有 MCP 服务部署,可能会产生服务器与网络资源成本,但客户端本身无需任何付费。

常见问题

Q1:MCP-Use 是否依赖特定模型厂商?

A1:不依赖。它可与任意支持工具调用的 LLM 协同使用,用户可自由切换模型源。

Q2:是否需要自建 MCP 服务器?

A2:不是必须。开发者可使用社区提供的公共 MCP 服务,也可根据需求自行部署,以获得更高的控制权。

Q3:如何保障工具调用的安全性?

A3:MCP-Use 提供访问控制与权限隔离机制,可在代理级别禁用特定类型的工具调用,如文件写入或网络访问,确保执行环境安全可控。

跳跳兔小结

MCP-Use 让“模型具备真实操作能力”成为可能。它以轻量级客户端的形式,为语言模型提供标准化工具访问接口,帮助开发者快速构建具备任务执行、系统集成和多工具协作能力的智能体。其优势在于通用性、高扩展性与安全控制机制,而限制在于仍需用户具备一定编程与部署经验。对于希望打造跨领域 AI 代理、实验智能工作流或研究模型外部交互的开发者而言,MCP-Use 是理想的起点。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...